最近国产 AI 大模型 DeepSeek 爆火出圈,登顶中美 App Store 下载榜,还在性能、性价比上碾压了 ChatGPT 和 Google Gemini 等硅谷巨头,直接杀入科技圈C位,成为现象级应用!

然而,不少小伙伴在使用的时候,经常会出现响应迟缓甚至宕机的情况👇

这可怎么办?

万幸的是,DeepSeek 是一个开源模型,这意味着我们可以将它部署在自己的电脑上,以便随时使用!

今天就跟大家分享一下,如何将 DeepSeek 部署在你的电脑上😃

Step 1 Ollama环境搭建

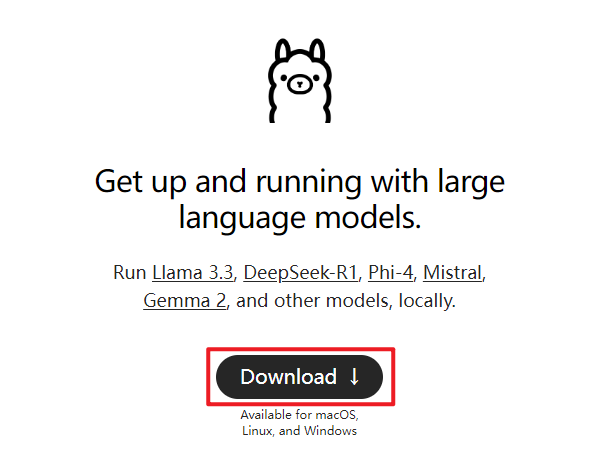

首先我们需要安装 Ollama,Ollama 是一个用于本地管理和运行大模型的工具,能够简化模型的下载和调度操作。

进入 Ollama 官网(ollama.com)。

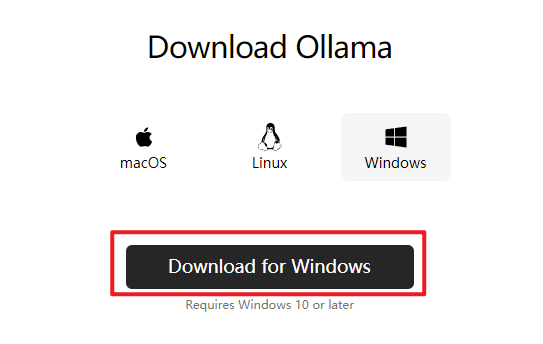

点击【Download】,选择适合自己系统的版本(Windows/mac/Linux)。

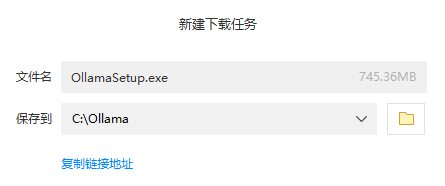

下载后点击安装,等待安装完成即可。最好安装到 C 盘,安装在其它盘,否则安装后可能需要重新配置环境变量。

Step 2 选择要安装的模型

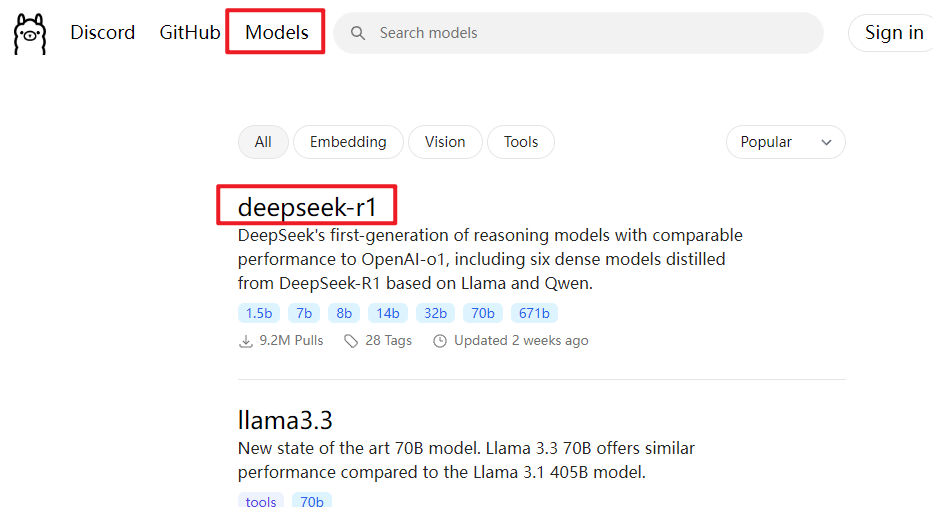

接着返回 Ollama 官网,点击右上角的【Models】,再选择【deepseek-r1】。

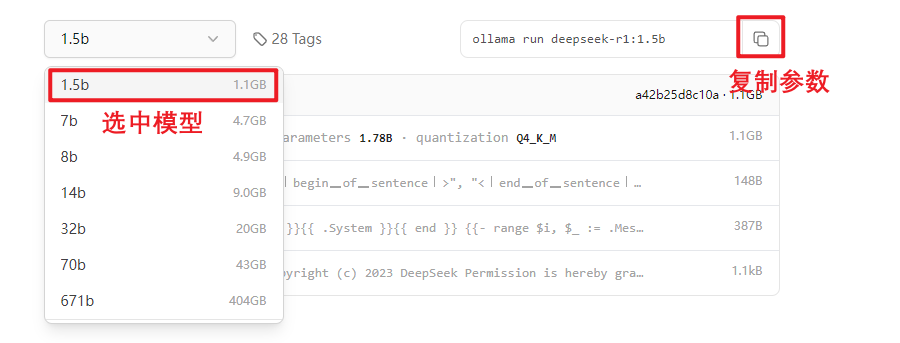

下拉可以看到多个参数版本,数字越大,模型参数越多,性能越强,对显存要求越高。

比如 1.5b 版本拥有15亿参数,显存要求相对较低( 2G 显存甚至核显也能跑),而更大参数的模型对显存要求自然水涨船高。

选中适合你电脑配置的版本(这里以 1.5b 为例),复制页面中显示的命令。

Step 3 安装模型

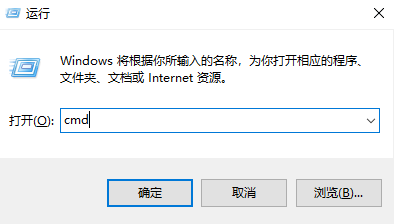

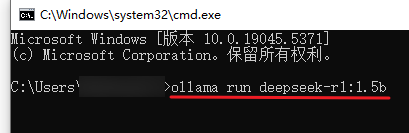

在 Windows 系统中,按下【Win+R】弹出如下窗口👇

输入【cmd】,点击【确定】,打开命令行。

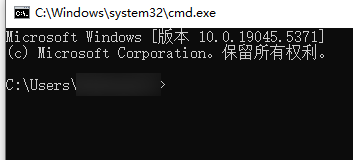

在命令行中粘贴刚才复制的命令,按下回车键后,系统会自动开始下载模型。

等待下载完成即可。

下载过程中若发现速度突然变慢,试着关闭命令行再重新打开。

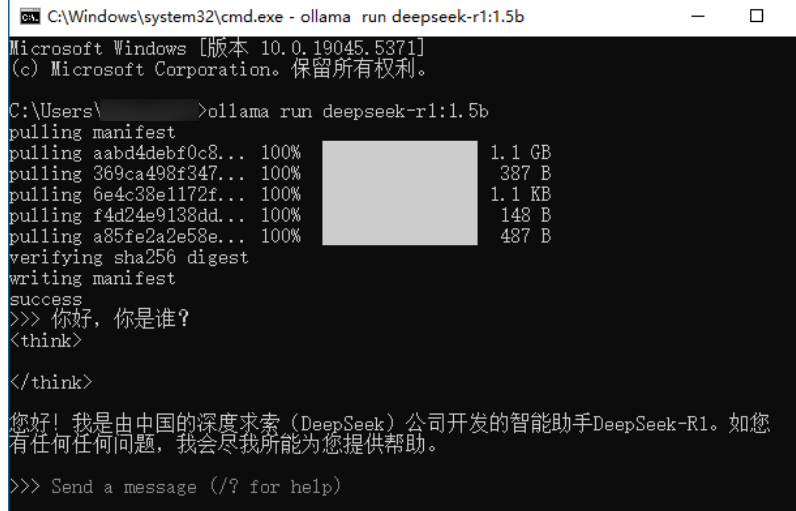

Step 4 开始对话

下载完成后,你的电脑就成功拥有了一个离线 DeepSeek,就算断网也能使用。

此时,你可以直接在命令行里输入问题,与模型开始互动。

Step 5 后续运行模型的小技巧

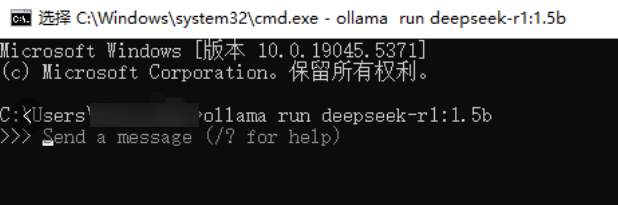

每次关机后,下次想与 DeepSeek 聊天,你还得重复启动命令行,输入下载时的命令即可。

这一点要牢记:点击桌面的 Ollama 图标只是启动了软件,要想真正开始对话,还得用命令行来“喊话”。

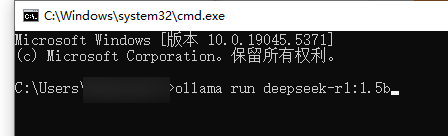

再次按下【Win+R】,在弹出的窗口里输入【cmd】,点击【确定】打开命令行。

在命令行界面,输入刚刚的命令【ollama run deepseek-r1:1.5b】,即可开始对话。

如果你不习惯在命令行窗口里面对话,或者希望有个更美观的交互界面,可以考虑安装 Open-WebUI。

不过这不是必须的,不熟悉电脑操作的小伙伴可以暂时跳过。

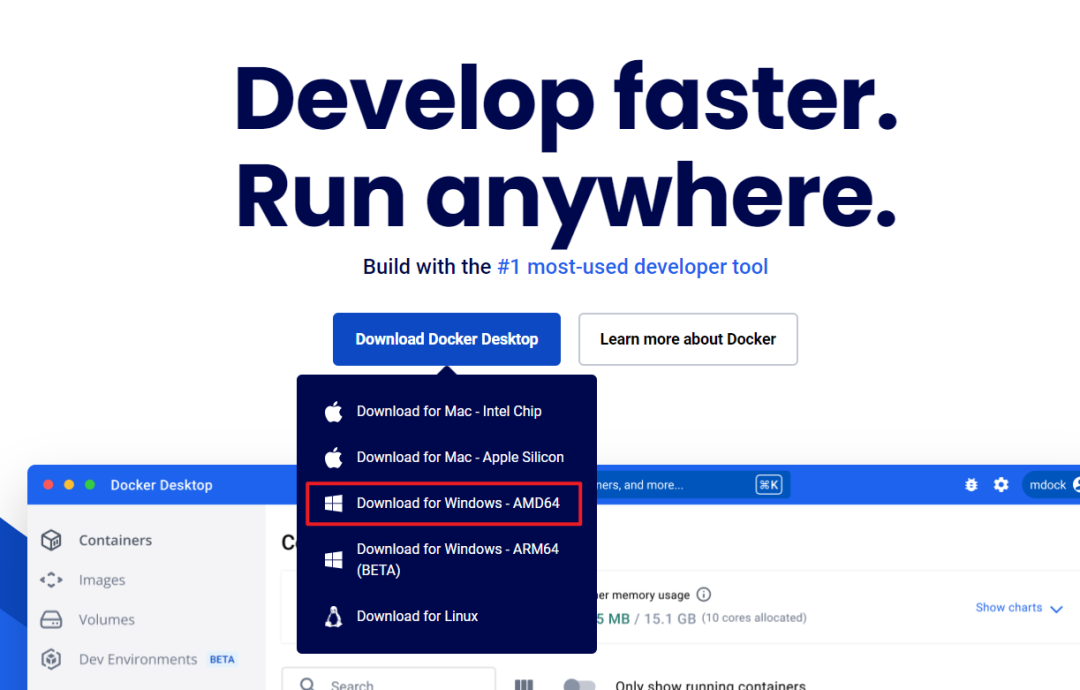

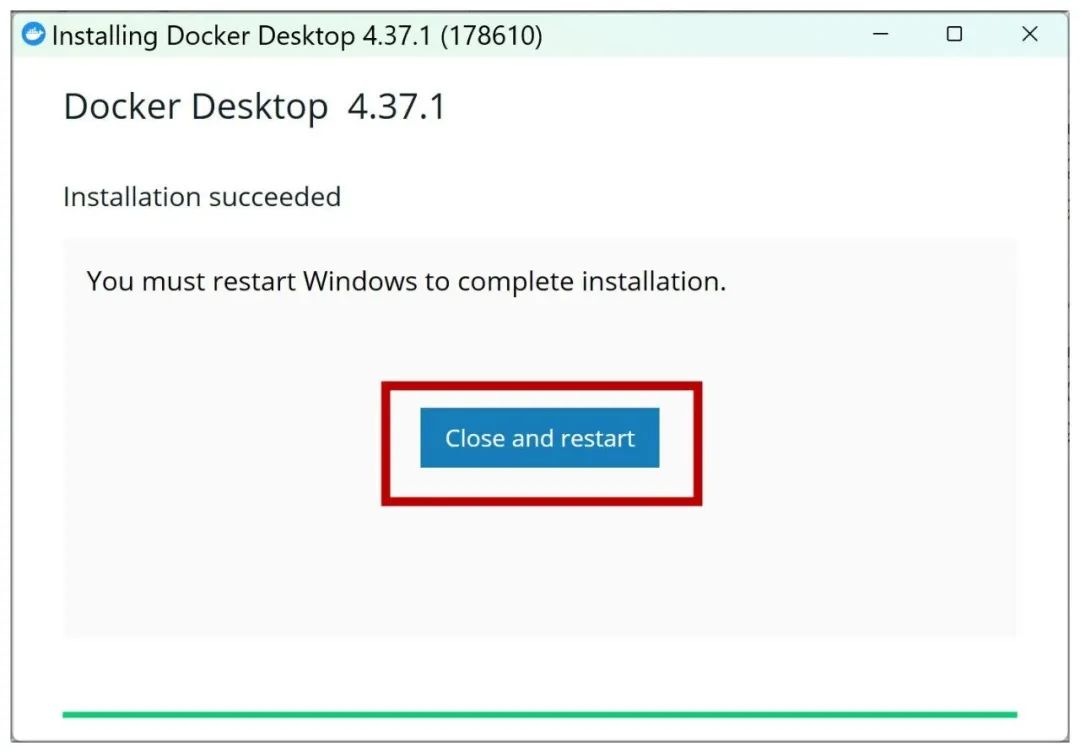

Step 6 安装 Docker

首先安装 Docker。

进入官网(www.docker.com),下载并安装适用于你系统的 Docker 桌面版。

按步骤下载安装即可,安装完成后需要重启电脑。

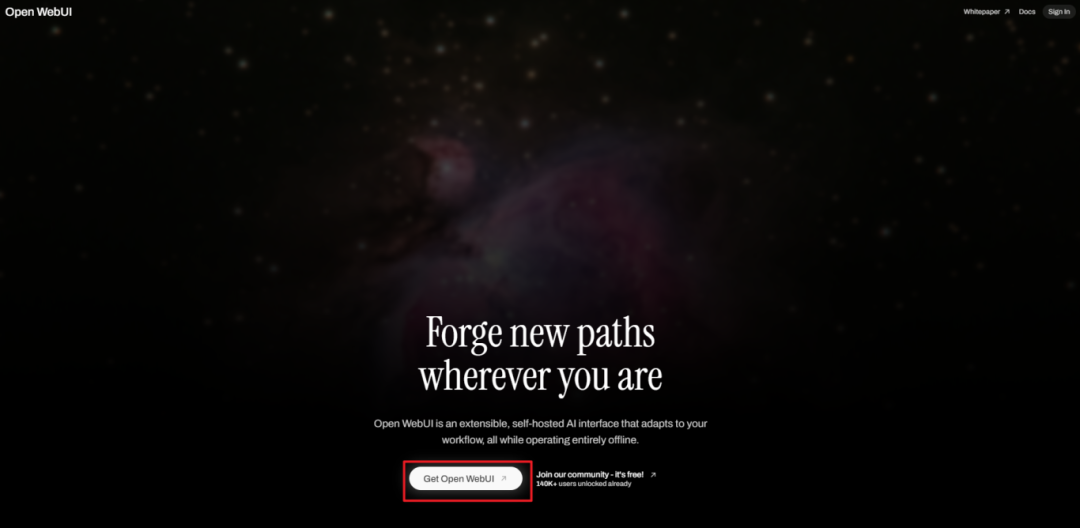

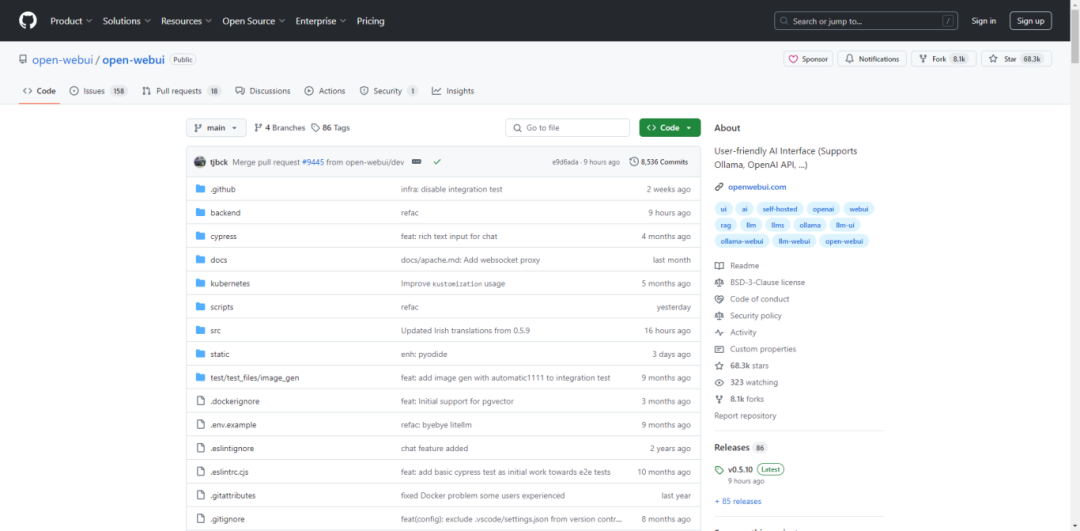

Step 7 安装 Open WebUI

进入 Open-WebUI 官网(openwebui.com)。

点击【Get Open WebUI】,来到 Open WebUI 的代码页。

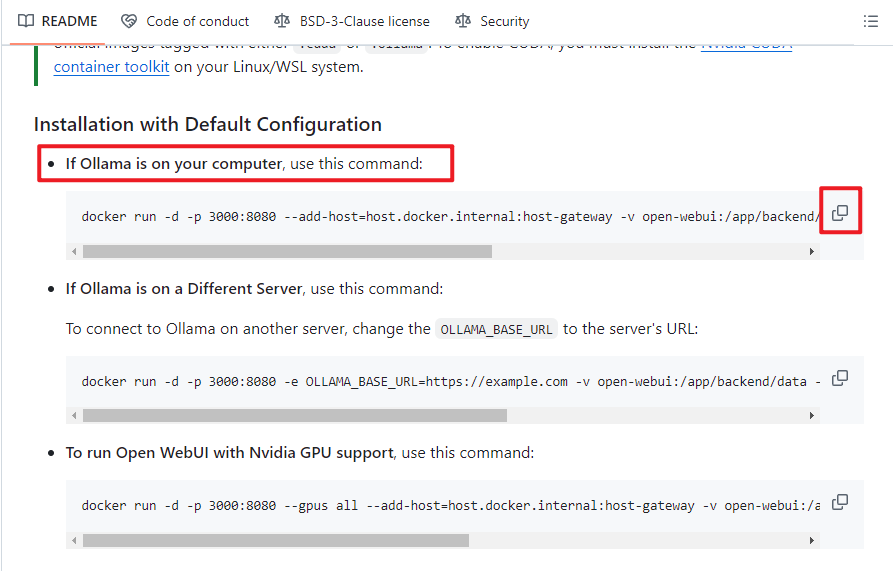

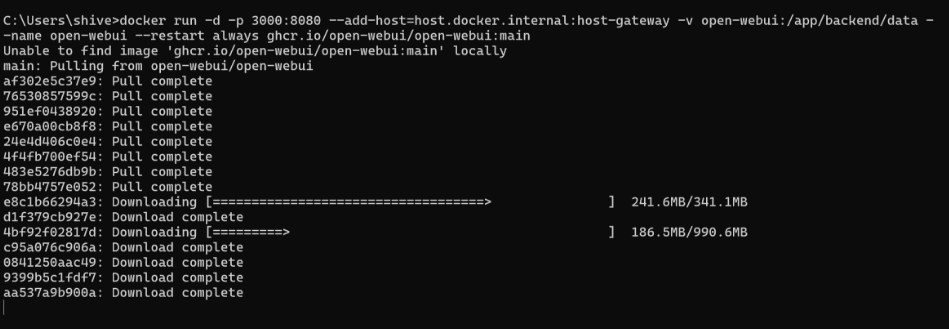

下滑找到【If Ollama is on your computer, use this command】,点击右边按钮复制这个指令。

再次打开命令窗口,粘贴复制的命令,安装 Open WebUI 即可。

Step 8 运行Open WebUI

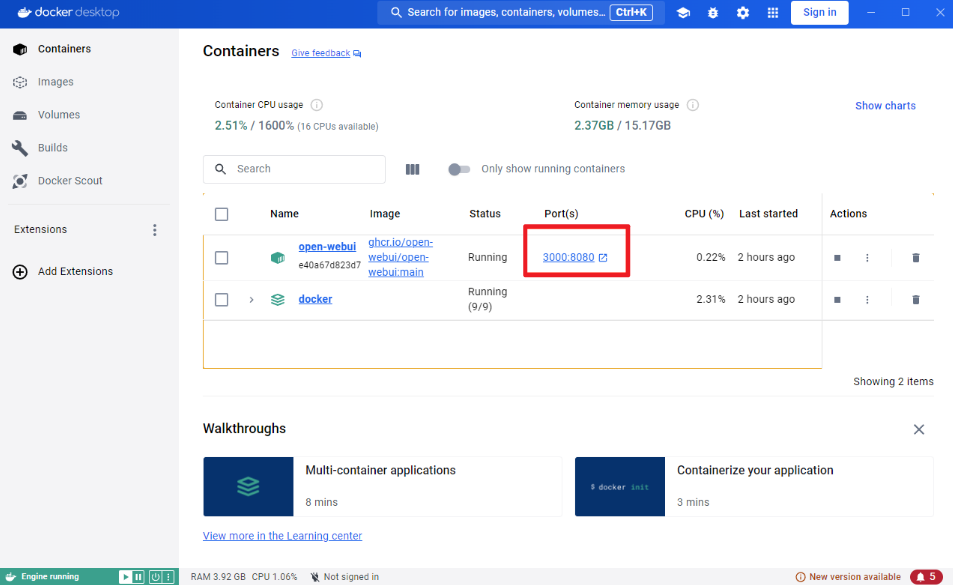

安装完成后,双击桌面上的 Docker 图标启动 Docker,再点击图片里框选的端口,即可运行 Open-WebUI。

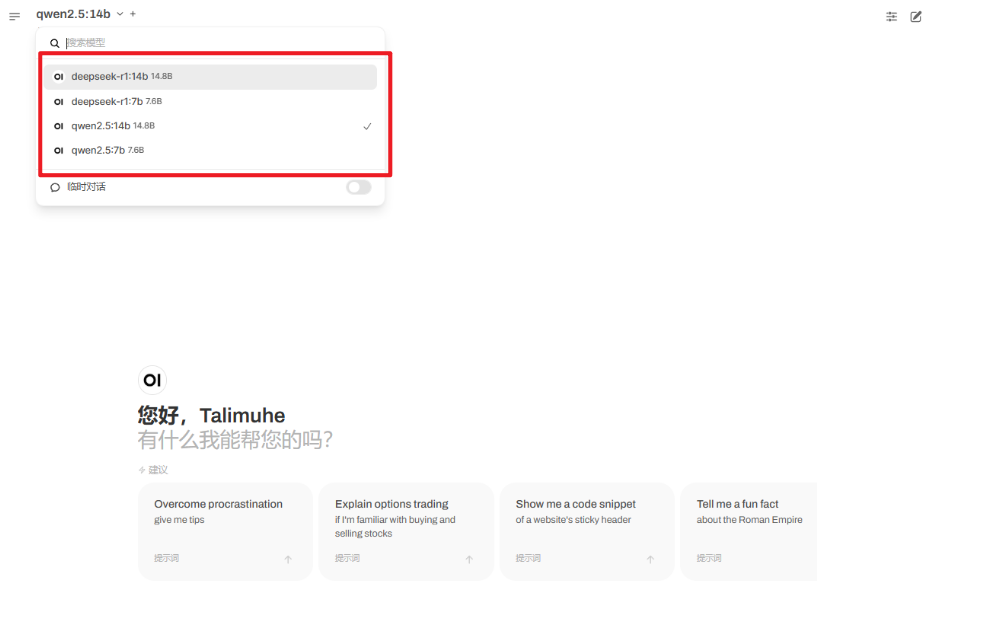

接着点击左上角,选择模型,就可以开始对话啦。

注意事项 一定要进行本地部署吗?

本地部署听起来酷炫,但并不是所有人都适用。

如果你使用AI的频率并不高,那么直接下载 DeepSeek APP 或使用网页版,也许是更好的选择,因为它们使用起来更方便。

部署 DeepSeek 到本地电脑主要适用于以下情况👇

1、 硬件条件充足

电脑配置较高,尤其是拥有独立显卡,能够满足较大模型的显存要求。

2、数据安全需求高

需要处理敏感或私密数据,不希望数据上传至云端。

3、高频调用任务

日常使用频率较高且调用 API 会产生较高成本,本地部署可以降低费用。

4、个性化定制需求

希望在开源模型基础上进行二次开发或定制调整,满足特殊业务需求。

通过本地部署,小伙伴们可以更好地保障数据安全、降低使用成本并实现定制化需求,如有需要,按着教程步骤试试吧~

免费AI编程助手

免费AI编程助手